구글 딥마인드와 스탠포드 대학이 mobile ALOHA라는 저가(총 제작비 $32,000(한화 4천만원 정도))의 로봇 프로젝트를 부품리스트, 하드웨어 코드, 소스 코드등 모든 것을 오픈소스로 공개했네요.

기존 로봇 학습이 테이블위에서의 조작같은 정적인 환경에 집중했기때문에 민첩성과 이동성등이 많이 부족했던 한계를 극복하고자 했다네요.

놀라운 게 고전적인 로봇 제어는 정교한 알고리즘을 기반으로 하는데, 이 프로젝트는 40~50번 정도 사람이 전신 원격 조작을 하게되면 이를 로봇이 모방 학습하여 스스로 정교한 작업을 수행할 수 있다고 하네요. 50번정도 시연을 통해 성공율을 90%까지 높일수 있다고 하네요.

놀랍게도 아래 영상을 보시면 꽤 정교한 동작인 후드티의 지퍼를 채워서 옷걸이에 걸어 정리한다든지, 병을 딴다든지, 청소를 하거나, 엘리베이터를 타서 스스로 이동하거나 새우 요리 또는 설거지를 하는 다양하게 비교적 간단한 모방 학습을 통해 할 수가 있네요.

https://youtu.be/HaaZ8ss-HP4?si=qssMwEz169gHsswb

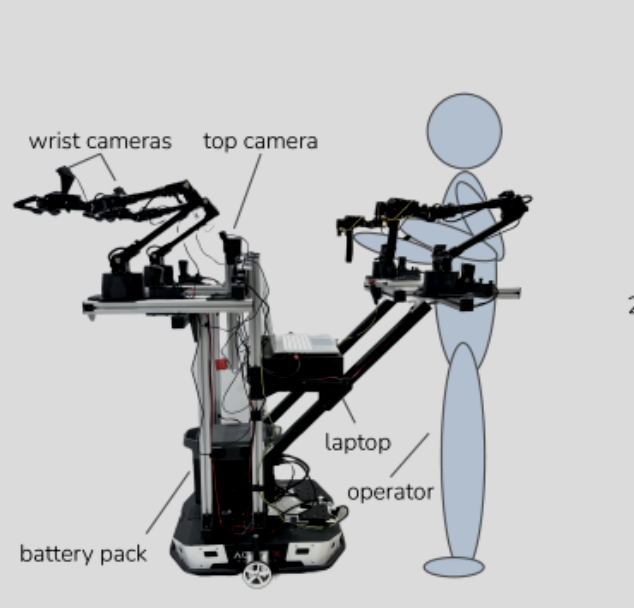

하드웨어 구성은

- 트레이서 역할인 AgileX Tracer AGV(최대 초속 1.6m)을 기반으로

- 로봇팔(ViperX 300)에 달린

- 2대의 카메라와 상단의 카메라1대(480x640 해상도 및 50Hz에서 Logitech C922x RGB 웹캠 3개),

- 그리고 12시간 이용이 가능한 배터리팩,

- 모든 데이터 수집 및 추론을 위한 노트북(Nvidia 3070 Ti GPU(8GB VRAM) 및 Intel i7-12800H 노트북)등으로 구성되어 있고, 이미지처럼 사람의 시연을 통해서 학습을 할 수 있습니다.

일반적으로 로봇 작업을 해결하기 위한 모방학습의 접근은 대상 작업을 위해 특정 로봇 하드웨어에서 수집된 데이터를 이용하는 것인데, 처음부터 데모데이터를 수집하는 긴 데이터 수집 프로세스의 어려움이 있고 특수한 데이터스로 학습된 정책은 제한된 시각적(조명 변경등) 다양성등에 한계가 많다고 하네요. 그래서 다르지만 유사한 유형의 로봇에서 수집된 다양한 실제 데이터 세트에 대한 공동 학습을 통해 단일 팔 조작에 대한 유망한 결과가 있다고 하네요. 논문에서도 공동 학습 파이프라인을 이용하기 위해 지퍼락 밀봉하기, 포크 집기, 사탕 포장하기, 종이 타월 찢기, 뚜껑이 있는 플라스틱 컵 열기, 탁구치기, 테이프 던지기, 커피머신 사용하기, 연필손 잡기, 벨크로 케이블 체결, 배터리 슬롯 삽입, 스크류 드라이버 처리등의 작업을 총 825번 시연하는 정적 ALOHA 데이터세트를 이용했다고 하네요.

mobile ALOHA를 이용해 수집된 데이터 기반의 지도 행동 복제(supervised behavior cloning)와 정적 알로하 데이터세트를 같이 이용하는 공동 학습(ACT, Diffusion Policy, VINN 등을 이용)을 통해서 성공률을 90%까지 올렸다고 하네요.

논문 제목은 "Mobile ALOHA: Learning Bimanual Mobile Manipulation with Low-Cost Whole-Body Teleoperation"입니다.

조만간 저렴하고 정교한 로봇들이 많이 등장하겠네요.

참고로 실패 사례도 올렸네요.

https://youtu.be/xGNNW6smDPQ?si=8RlmFThn8t-PoGoX

자세한 내용은 아래를 참고하시면 좋을 거 같네요.

저자의 유튜브 : https://www.youtube.com/@zipengfu

Zipeng Fu

www.youtube.com

프로젝트 웹사이트 : https://mobile-aloha.github.io/

Mobile ALOHA: Learning Bimanual Mobile Manipulation with Low-Cost Whole-Body Teleoperation

by Zipeng Fu*, Tony Z. Zhao* and Chelsea Finn at Stanford

mobile-aloha.github.io

'SmartTech' 카테고리의 다른 글

| [AI기반서비스-clipdrop] 간단한 이미지 편집 서비스 (0) | 2023.10.27 |

|---|---|

| [AI기반 서비스] Roam Around 여행 일정 서비스 (0) | 2023.10.27 |

| [AI기반 서비스-Upscayl] 저해상도 이미지를 고해상도로 업스케일해주는 서비스 (0) | 2023.10.25 |

| [AI기반 서비스-AI Comic Factory] 이젠 웹툰도 AI가 알아서 그려준다. (0) | 2023.10.24 |

| [AI기반 서비스] 여행 영상을 보면서 여행을 짜는 서비스 - 비트리비 (0) | 2023.08.30 |